Każdy zawodowy astronauta powinien mieć jakieś pojęcie elektryczne, wiedzieć co to jest plazma i dlaczego Wszechświat jest przede wszystkim ELEKTRYCZNY. Astrofizyk nie studiujący zjawisk elektrycznych , nie ma bladego pojęcia co dzieje się w przestrzeni kosmicznej. Wskazane byłoby także chociaż jakieś minimalne przeszkolenie potencjalnego astronauty w tym kierunku. Dawniej każdy kapłan biorący udział w obsłudze biblijnej "Arki Przymierza" musiał mieć pojęcie o elektryczności. Inaczej praca w pobliżu i w kontakcie z urządzeniem elektrycznym mogłaby go zabić tak jak to się działo z osobami postronnymi zapewne wtedy i w obecnych czasach. Przykładowo jak z pakistańskimi amatorami pozującymi do zdjęć na dachu wagonu kolejowego.

Przestrzeń kosmiczną należy rozumieć jako niezły kawał przewodnika elektrycznego tyle że o najwyższej oporności ze wszystkich dostępnych substancji. Wszystkie substancje są w pewnej mierze przewodnikami jak też izolatorami. Za przenoszenie energii odpowiadają fotony. Bez wyjątku o jakim rodzaju energii czy oddziaływania mówimy. Materia zbudowana jest z fotonów przechwyconych na atomowych orbitalach. Nie istnieją elektrony. Za elektrony wzięto mylnie orbitale atomowe które są wirami elektromagnetycznymi pełnymi fotonów. Tak jak z resztą wszystkie inne pola elektromagnetyczne. W tym kontekście przestrzeń która potrzebuje transmitera energii świetlnej, cieplnej jak i pozostałych, jest przewodnikiem wypełnionym fotonami o niesamowicie ogromnym potencjale elektrycznym ponieważ przekrój przewodnika jest nam nie znany. I mimo że fotony są określone jako bez-masowe oraz nie– elektryczne to nie jest tak do końca. Sprawdźmy przewodność elektryczną tak zwanej próżni -8,84·10−12 F/m. Jeśli tak zwana próżnia ma swoją przenikalność elektryczną to jednak nie jest to próżnia. Gdyby przestrzeń kosmiczna była próżnią bez jakiejkolwiek cząsteczki NIE POWINNA W OGÓLE PRZEWODZIĆ GRAMA ENERGII!! Jeśli przestrzeń kosmiczna ulega przebiciu elektrycznemu to znaczy że jest tam materiał który temu przebiciu ulega.

Nie mówię tu o odwracaniu uwagi jak kota ogonem jaki stosują lemingi nauki mówiąc że w przestrzeni nie ma próżni bo mamy przecież cząsteczki typu gazy, pyły, itp które spotyka się raz na centymetr czy metr. To nie o tym mówimy. To nie spowoduje przeniesienia ładunku "elektrycznego". Mówię o obecności fotonów obrazowo mówiąc umieszczonych jeden przy drugim, będących w stanie bardzo niskiego potencjału. Można też równie dobrze powiedzieć że gdy fotony czyli eter nie jest w ruchu wtedy przestrzeń jest monolitem wypełnionym jednorodną substancją. Można uformować twierdzenie że "ładunek elektryczny to jest zdolność do przenoszenia poprzez fotony, energii elektrycznej z punktu o większej ich ilości do punktu o ilości mniejszej".

W pozornie pustej monolitycznej przestrzeni jako pierwszym stanie skupienia, fotonowa przestrzeń którą pod względem strukturalnym możemy opisać jako jeden nieruchomy foton w stanie niskiej energii mamy jeszcze takie zjawisko jak plazma.

Plazma to drugi stan skupienia występujący we Wszechświecie w wielokrotnie większej ilości niż następujące po nim gazy, ciecze czy występujący w najmniejszej ilości 5-ty stan stały. Oczywiście odwraca to teorię Big Bangu do góry nogami, według której do dziś plazmy pozostało najmniej ze wszystkich stanów skupienia.

Zgodnie z obecną fizyką "kiedy jeden lub więcej zewnętrznych walencyjnych elektronów (chmur fotonowych = orbitali - przypis mój) zostanie oddzielonych od atomu, mówimy, że atom jest zjonizowany. Wykazuje wówczas dodatni ładunek elektryczny, i jest zwany jonem dodatnim.

Z drugiej strony, jeśli dodatkowy elektron (chmura fotonowa) jest dodany do obojętnego elektrycznie atomu, zyskuje on ładunek ujemny, i jest nazywany jonem ujemnym."

Zgodnie z obecną fizyką "kiedy jeden lub więcej zewnętrznych walencyjnych elektronów (chmur fotonowych = orbitali - przypis mój) zostanie oddzielonych od atomu, mówimy, że atom jest zjonizowany. Wykazuje wówczas dodatni ładunek elektryczny, i jest zwany jonem dodatnim.

Z drugiej strony, jeśli dodatkowy elektron (chmura fotonowa) jest dodany do obojętnego elektrycznie atomu, zyskuje on ładunek ujemny, i jest nazywany jonem ujemnym."

Siły elektryczne pomiędzy jonami o różnym potencjale są rzędy wielkości większe, niż siły mechaniczne, np wytwarzane grawitacją (jest to tylko stały słaby wielkopowierzchniowy prąd protofotonowy). Elektryczna plazma jest chmurą "jonów" i "elektronów" (wszystko zbudowane z fotonów), które, na skutek wzbudzenia pod wpływem pól elektromagnetycznych, mogą zaświecić i zachowywać się w niezwykły sposób.

Najbardziej znanymi przykładami elektrycznej plazmy są lampy neonowe, błyskawice czy spawarka. Ziemska jonosfera jest przykładem plazmy, która nie emituje widzialnego światła. Plazma wypełnia przestrzeń naszego Układu Słonecznego. Chmura cząstek tworzących wiatr słoneczny jest plazmą. Cała nasza Droga Mleczna składa się głównie z plazmy. W rzeczywistości, 99% widzialnego materialnego Wszechświata jest plazmą a astronauci jakby tego wszystkiego było mało, twierdzą że przestrzeń kosmiczna śmierdzi SPALONYM METALEM! Więc przestrzeń kosmiczna jest typowo elektrycznym zjawiskiem W CAŁOŚCI , z małymi wyjątkami na powierzchni żywych biologicznie planet i może gdzieś tam większych księżyców.

Pod koniec XIX wieku, Norweg, fizyk, Kristian Birkeland wyjaśnił, że powodem dla którego widzimy zorze polarne, jest ich plazmowa natura. Odkrył również zwinięte, korkociągowe ścieżki prądu elektrycznego w plazmie. Czasami są one widoczne, czasem nie - zależy to od gęstości prądu w plazmie. Dzisiaj, te strugi jonów i elektronów nazywane są prądami Birkelanda. Tajemnicze Ognie Świętego Elma, elfy, dżety i niebieskie fontanny, związane z burzami elektrycznymi na Ziemi, są przykładami takich właśnie prądów biorących początek w plazmie górnej atmosfery.

Na początku XX wieku, laureat nagrody Nobla, Irwing Langmuir, studiował elektryczną plazmę w swoim laboratorium w General Electric. Rozwinął on wiedzę na temat inicjowania prądów Birkelanda. W istocie to on pierwszy użył słowa plazma na określenie samoorganizującego się zjonizowanego gazu, w obecności prądów elektrycznych i pól magnetycznych.

2 Tryb żarzenia - natężenie prądu elektrycznego jest znaczne. Plazma się jarzy. Jasność jarzenia zależy od jeszcze większej ilości i prędkości jonów wchodzących w skład prądu. Przykłady: lampa neonowa, mgławica emisyjna, powierzchnia Słońca i innych gwiazd.

3 Tryb łuku - natężenie i prędkość strumienia prądu jest już bardzo wysokie. Plazma silnie promieniuje w całym widmie. Prąd ma tendencje do tworzenia skręconych włókien. Przykładami takiego trybu są spawarka, błyskawica, wyładowania pomiędzy blisko położonymi ciałami niebieskimi jak pulsary, fotosfery gwiazd i słoneczna.

(4. Tryb protoplazmy lub pierwszy stan skupienia- przestrzenny- prąd praktycznie nie płynie, plazma w stanie ruchu bliskim zerowego (fotony przed uzyskaniem ruchu- energii lub po utracie energii) wypełnia cały Wszechświat POD CIŚNIENIEM - przyp. mój)

Najbardziej znanymi przykładami elektrycznej plazmy są lampy neonowe, błyskawice czy spawarka. Ziemska jonosfera jest przykładem plazmy, która nie emituje widzialnego światła. Plazma wypełnia przestrzeń naszego Układu Słonecznego. Chmura cząstek tworzących wiatr słoneczny jest plazmą. Cała nasza Droga Mleczna składa się głównie z plazmy. W rzeczywistości, 99% widzialnego materialnego Wszechświata jest plazmą a astronauci jakby tego wszystkiego było mało, twierdzą że przestrzeń kosmiczna śmierdzi SPALONYM METALEM! Więc przestrzeń kosmiczna jest typowo elektrycznym zjawiskiem W CAŁOŚCI , z małymi wyjątkami na powierzchni żywych biologicznie planet i może gdzieś tam większych księżyców.

Na zdjęciu Kristian Birkeland w swoim laboratorium.

Pod koniec XIX wieku, Norweg, fizyk, Kristian Birkeland wyjaśnił, że powodem dla którego widzimy zorze polarne, jest ich plazmowa natura. Odkrył również zwinięte, korkociągowe ścieżki prądu elektrycznego w plazmie. Czasami są one widoczne, czasem nie - zależy to od gęstości prądu w plazmie. Dzisiaj, te strugi jonów i elektronów nazywane są prądami Birkelanda. Tajemnicze Ognie Świętego Elma, elfy, dżety i niebieskie fontanny, związane z burzami elektrycznymi na Ziemi, są przykładami takich właśnie prądów biorących początek w plazmie górnej atmosfery.

Na początku XX wieku, laureat nagrody Nobla, Irwing Langmuir, studiował elektryczną plazmę w swoim laboratorium w General Electric. Rozwinął on wiedzę na temat inicjowania prądów Birkelanda. W istocie to on pierwszy użył słowa plazma na określenie samoorganizującego się zjonizowanego gazu, w obecności prądów elektrycznych i pól magnetycznych.

Istnieją trzy różne stany funkcjonowania plazmy:

1 Tryb ciemnego prądu - natężenie prądu elektrycznego (prędkość przepływu zróżnicowanych ilościowo fotonów na orbitalach jonów) wewnątrz plazmy jest niewielkie. Plazma nie świeci. Jest całkowicie niewidoczna. Nie wiemy o jej istnieniu, dopóki nie zmierzymy aktywności elektrycznej czułymi instrumentami. Obecnie przykładami plazmy operującej w ciemnym trybie są włókna plazmowe łączące magnetosfery galaktyk, gwiazd, planet a także ich magnetosfery.

1 Tryb ciemnego prądu - natężenie prądu elektrycznego (prędkość przepływu zróżnicowanych ilościowo fotonów na orbitalach jonów) wewnątrz plazmy jest niewielkie. Plazma nie świeci. Jest całkowicie niewidoczna. Nie wiemy o jej istnieniu, dopóki nie zmierzymy aktywności elektrycznej czułymi instrumentami. Obecnie przykładami plazmy operującej w ciemnym trybie są włókna plazmowe łączące magnetosfery galaktyk, gwiazd, planet a także ich magnetosfery.

2 Tryb żarzenia - natężenie prądu elektrycznego jest znaczne. Plazma się jarzy. Jasność jarzenia zależy od jeszcze większej ilości i prędkości jonów wchodzących w skład prądu. Przykłady: lampa neonowa, mgławica emisyjna, powierzchnia Słońca i innych gwiazd.

3 Tryb łuku - natężenie i prędkość strumienia prądu jest już bardzo wysokie. Plazma silnie promieniuje w całym widmie. Prąd ma tendencje do tworzenia skręconych włókien. Przykładami takiego trybu są spawarka, błyskawica, wyładowania pomiędzy blisko położonymi ciałami niebieskimi jak pulsary, fotosfery gwiazd i słoneczna.

(4. Tryb protoplazmy lub pierwszy stan skupienia- przestrzenny- prąd praktycznie nie płynie, plazma w stanie ruchu bliskim zerowego (fotony przed uzyskaniem ruchu- energii lub po utracie energii) wypełnia cały Wszechświat POD CIŚNIENIEM - przyp. mój)

We wszystkich tych trybach plazma emituje mierzalne promieniowanie elektromagnetyczne (szum radiowy). Przez cały czas gęstość prądu (ampery na metr kwadratowy) determinuje stan, w jakim znajduje się plazma. Atomowa struktura jonizowanego gazu również ma na to wpływ.

Jedną z najbardziej istotnych właściwości plazmy jest jej zdolność do samo organizacji - czyli elektrycznego izolowania się jednych jej części od pozostałych.

Jedną z najbardziej istotnych właściwości plazmy jest jej zdolność do samo organizacji - czyli elektrycznego izolowania się jednych jej części od pozostałych.

Osobiście uważam że plazma jest wręcz świadoma, tak samo jak cała przestrzeń jest monolitem świadomości. Warstwa izolacyjna nazywana jest warstwą podwójną (DL). Gdy studiuje się plazmę w laboratorium, jest ona z reguły zamknięta w cylindrycznej szklanej tubie. Na obu końcach tuby znajdują się elektrody. Jedna elektroda (zwana anodą) posiada większy woltaż niż druga (katoda). Przy takim ustawieniu następuje jonizacja i zaczyna płynąć prąd. Jony dodatnie (atomy pozbawione części "elektronów"[fotonów]) oddalają się od anody, a jony ujemne (atomy z dodatkowymi "elektronami"[fotonami]) będą się do niej przybliżać. Matematyczna suma tych dwóch przeciwnie skierowanych przepływów jest całkowitym prądem płynącym w plazmie.

Jeżeli różnica potencjałów pomiędzy elektrodami jest wystarczająco duża, gdzieś pomiędzy nimi uformuje się warstwa podwójna. Skupi się na niej niemal cały spadek napięcia, przyłożony pomiędzy elektrody. Plazma po stronie anody będzie miała w przybliżeniu taki sam woltaż, jak anoda, zaś plazma po drugiej stronie - jak katoda. Obie części plazmy będą od siebie odizolowane przez DL. Cząstki po jednej stronie DL nie odczuwają pola elektrycznego, ze względu na równoważący ładunek po drugiej. Niemniej całkowity prąd elektryczny, jest wszędzie taki sam (po obu stronach DL). Plazma jest doskonałym przewodnikiem, a co za tym idzie, nie ma na niej znaczącego spadku napięcia podczas przewodzenia prądu - stąd potrzeba warstwy podwójnej, która bierze na siebie większość spadku napięcia. Innymi słowy, DL znajduje się tam, gdzie jest w plazmie najsilniejsze pole elektryczne.

Jeśli włoży się do plazmy ciało obce, utworzy się wokół niego warstwa podwójna, izolująca go od reszty plazmy. Efekt ten stwarza problemy z wykrywaniem napięcia w plazmie przez sondy, w celu zmierzenia potencjału w danym miejscu. Jest to dobrze znana właściwość plazmy. W laboratorium rozwinięto wiele metod, aby to ominąć.

W kosmosie niemożliwym jest wysłać próbnik, aby zmierzyć woltaż słonecznej plazmy w jakimś miejscu. Woltaż jest wielkością względną (jak prędkość), musi być mierzony względem czegoś. Próbnik zacząłby podróż, mając woltaż równy powierzchni Ziemi. W miarę przedzierania się przez plazmę słoneczną, będzie zmieniał potencjał i przejmował woltaż danego miejsca aczkolwiek w kosmosie można zmierzyć natężenie pola elektrycznego.

Prąd elektryczny, przechodzący przez plazmę, przyjmuje skręconą formę, odkrytą przez Birkelanda. Prądy Birkelanda najczęściej pojawiają się w parach. Pary te mają tendencję do ściskania pomiędzy sobą dowolnego materiału za pomocą silnego pola elektromagnetycznego (szybki masowy ruch eteru (mas fotonowych) w plazmie. Nazywa się to skurczem "Z". W ten sposób w kosmicznej skali włóknach prądowych powstały galaktyki spiralne. Patrz symetryczny dimorficzny tależowy układ tych galaktyk.

Jeśli włoży się do plazmy ciało obce, utworzy się wokół niego warstwa podwójna, izolująca go od reszty plazmy. Efekt ten stwarza problemy z wykrywaniem napięcia w plazmie przez sondy, w celu zmierzenia potencjału w danym miejscu. Jest to dobrze znana właściwość plazmy. W laboratorium rozwinięto wiele metod, aby to ominąć.

W kosmosie niemożliwym jest wysłać próbnik, aby zmierzyć woltaż słonecznej plazmy w jakimś miejscu. Woltaż jest wielkością względną (jak prędkość), musi być mierzony względem czegoś. Próbnik zacząłby podróż, mając woltaż równy powierzchni Ziemi. W miarę przedzierania się przez plazmę słoneczną, będzie zmieniał potencjał i przejmował woltaż danego miejsca aczkolwiek w kosmosie można zmierzyć natężenie pola elektrycznego.

Prąd elektryczny, przechodzący przez plazmę, przyjmuje skręconą formę, odkrytą przez Birkelanda. Prądy Birkelanda najczęściej pojawiają się w parach. Pary te mają tendencję do ściskania pomiędzy sobą dowolnego materiału za pomocą silnego pola elektromagnetycznego (szybki masowy ruch eteru (mas fotonowych) w plazmie. Nazywa się to skurczem "Z". W ten sposób w kosmicznej skali włóknach prądowych powstały galaktyki spiralne. Patrz symetryczny dimorficzny tależowy układ tych galaktyk.

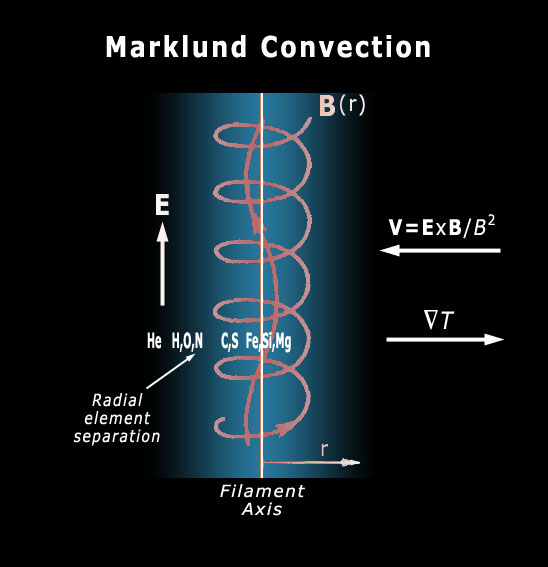

Zdolność prądu Birkelanda do gromadzenia i kompresowania nawet nie zjonizowanego materiału nazywa się konwekcją Marklunda.

Przez lata zakładano, że plazma jest doskonałym przewodnikiem, do tego stopnia, że każde pole magnetyczne w niej powstałe będzie w nią "wmrożone".

Techniczne wyjaśnienie jest następujące: jedno z równań Maxwella wskazuje, że pole elektryczne w regionie jest zerowe, to pole magnetyczne musi być tam niezmienne względem czasu - stałe. Jeśli więc każda plazma jest doskonałym przewodnikiem (czyli nie może posiadać pola elektrycznego - a więc różnicy potencjałów), wówczas każde pole magnetyczne wewnątrz niej musi być zamrożone - czyli nie może się w żaden sposób zmieniać.

Obecnie wiemy, że między różnymi punktami w plazmie mogą być niewielkie różnice potencjału. Inżynier plazmowy Hannes Alfvén wskazał na ten fakt podczas swojego przemówienia po otrzymaniu nagrody Nobla z fizyki w 1970. Przewodność elektryczna każdego materiału, z plazmą włącznie, zdeterminowana jest przez dwa czynniki: gęstość dostępnych nośników (jonów) w materiale, oraz ich ruchliwość. W plazmie, ruchliwość nośników jest ogromna. Jony i "elektrony" mogą się poruszać w przestrzeni kosmicznej bardzo swobodnie. Ale ich koncentracja (ilość na jednostkę objętości) może w ogóle nie być duża, jeśli plazma jest pod niskim ciśnieniem. Tak więc, chociaż plazma jest bardzo dobrym przewodnikiem, mogą w niej występować słabe pola elektryczne.

Plazma nie jest doskonałym przewodnikiem, jest odpowiednikiem kabli przesyłających prąd. Jest to dobrze znane zjawisko, że jeśli jakiś przewodnik przecina pole magnetyczne, zaczyna w nim płynąć prąd. Na tej zasadzie działają prądnice i alternatory. A zatem, jeżeli dojdzie do względnego ruchu plazmy, powiedzmy w ramieniu galaktyki, i pola magnetycznego w tym samym miejscu, w plazmie popłynie prąd Birkelanda. Prąd ten wytworzy z kolei własne pole magnetyczne.

Zjawiska plazmowe są skalowalne. Oznacza to, że elektryczne i fizyczne właściwości plazmy pozostają takie same, niezależnie od jej rozmiaru. Oczywiście, zjawiska dynamiczne zachodzą znacznie szybciej w małym laboratorium niż w galaktyce. Są one jednak identyczne, gdyż wynikają z tych samych praw fizyki. Mamy więc odpowiedni sposób do symulowania kosmicznej plazmy w laboratorium i generowania efektów dokładnie takich, jak w przestrzeni kosmicznej. W rzeczywistości, prądy elektryczne w plazmie powodują większość zjawisk obserwowanych astronomicznie, które nie są możliwe do wyjaśnienia tylko przy pomocy grawitacji oraz magnetyzmu.

Dlaczego astrofizycy ignorują zjawiska elektryczne?

Skoro położono tak mocny fundament pod pracę nad elektrycznymi własnościami Wszechświata, dlaczego główny nurt astrofizyki wciąż ignoruje to pole badań, zamiast tego łatając swoje upadające, grawitocentryczne modele coraz większą ilością teoretycznych fikcji? Dlaczego konwencjonalni astronomowie i kosmologowie systematycznie wyłączają pola elektryczne oraz prądy nie tylko ze swoich rozważań, ale i ze swoich programów? Dlaczego świadomie ignorują fakt, że wiele niewyjaśnionych zjawisk da się łatwo wyjaśnić poprzez rozpoznanie istnienia pól i prądów elektrycznych w plazmie słonecznej i galaktycznej?

Odpowiedź brzmi: magnetyzm był znany od średniowiecza. Nawet już wcześniej wiedziano, że kawałek żelaza może oddziaływać z innym na odległość, choć nie wyjaśniono mechanizmu pola elektromagnetycznego do dzisiaj.

Ale wcześni astronomowie (jak ich współcześni kuzyni) nie byli uprzedzeni o istnieniu zjawisk elektrycznych. Johannes Kepler (1571-1630) wyjaśnił już matematycznie kształt orbit planet, gdy Izaak Newton opublikował swój traktat o grawitacji w 1687. Gdy to nastąpiło, nic więcej nie było potrzebne do wyjaśnienia i przewidywania ruchów planet. Wszystko było rozwiązane. Aż do dzisiaj...

Przez lata zakładano, że plazma jest doskonałym przewodnikiem, do tego stopnia, że każde pole magnetyczne w niej powstałe będzie w nią "wmrożone".

Techniczne wyjaśnienie jest następujące: jedno z równań Maxwella wskazuje, że pole elektryczne w regionie jest zerowe, to pole magnetyczne musi być tam niezmienne względem czasu - stałe. Jeśli więc każda plazma jest doskonałym przewodnikiem (czyli nie może posiadać pola elektrycznego - a więc różnicy potencjałów), wówczas każde pole magnetyczne wewnątrz niej musi być zamrożone - czyli nie może się w żaden sposób zmieniać.

Obecnie wiemy, że między różnymi punktami w plazmie mogą być niewielkie różnice potencjału. Inżynier plazmowy Hannes Alfvén wskazał na ten fakt podczas swojego przemówienia po otrzymaniu nagrody Nobla z fizyki w 1970. Przewodność elektryczna każdego materiału, z plazmą włącznie, zdeterminowana jest przez dwa czynniki: gęstość dostępnych nośników (jonów) w materiale, oraz ich ruchliwość. W plazmie, ruchliwość nośników jest ogromna. Jony i "elektrony" mogą się poruszać w przestrzeni kosmicznej bardzo swobodnie. Ale ich koncentracja (ilość na jednostkę objętości) może w ogóle nie być duża, jeśli plazma jest pod niskim ciśnieniem. Tak więc, chociaż plazma jest bardzo dobrym przewodnikiem, mogą w niej występować słabe pola elektryczne.

Plazma nie jest doskonałym przewodnikiem, jest odpowiednikiem kabli przesyłających prąd. Jest to dobrze znane zjawisko, że jeśli jakiś przewodnik przecina pole magnetyczne, zaczyna w nim płynąć prąd. Na tej zasadzie działają prądnice i alternatory. A zatem, jeżeli dojdzie do względnego ruchu plazmy, powiedzmy w ramieniu galaktyki, i pola magnetycznego w tym samym miejscu, w plazmie popłynie prąd Birkelanda. Prąd ten wytworzy z kolei własne pole magnetyczne.

Zjawiska plazmowe są skalowalne. Oznacza to, że elektryczne i fizyczne właściwości plazmy pozostają takie same, niezależnie od jej rozmiaru. Oczywiście, zjawiska dynamiczne zachodzą znacznie szybciej w małym laboratorium niż w galaktyce. Są one jednak identyczne, gdyż wynikają z tych samych praw fizyki. Mamy więc odpowiedni sposób do symulowania kosmicznej plazmy w laboratorium i generowania efektów dokładnie takich, jak w przestrzeni kosmicznej. W rzeczywistości, prądy elektryczne w plazmie powodują większość zjawisk obserwowanych astronomicznie, które nie są możliwe do wyjaśnienia tylko przy pomocy grawitacji oraz magnetyzmu.

Dlaczego astrofizycy ignorują zjawiska elektryczne?

Skoro położono tak mocny fundament pod pracę nad elektrycznymi własnościami Wszechświata, dlaczego główny nurt astrofizyki wciąż ignoruje to pole badań, zamiast tego łatając swoje upadające, grawitocentryczne modele coraz większą ilością teoretycznych fikcji? Dlaczego konwencjonalni astronomowie i kosmologowie systematycznie wyłączają pola elektryczne oraz prądy nie tylko ze swoich rozważań, ale i ze swoich programów? Dlaczego świadomie ignorują fakt, że wiele niewyjaśnionych zjawisk da się łatwo wyjaśnić poprzez rozpoznanie istnienia pól i prądów elektrycznych w plazmie słonecznej i galaktycznej?

Odpowiedź brzmi: magnetyzm był znany od średniowiecza. Nawet już wcześniej wiedziano, że kawałek żelaza może oddziaływać z innym na odległość, choć nie wyjaśniono mechanizmu pola elektromagnetycznego do dzisiaj.

Ale wcześni astronomowie (jak ich współcześni kuzyni) nie byli uprzedzeni o istnieniu zjawisk elektrycznych. Johannes Kepler (1571-1630) wyjaśnił już matematycznie kształt orbit planet, gdy Izaak Newton opublikował swój traktat o grawitacji w 1687. Gdy to nastąpiło, nic więcej nie było potrzebne do wyjaśnienia i przewidywania ruchów planet. Wszystko było rozwiązane. Aż do dzisiaj...

Było to oczywiście na długo przed Benjaminem Franklinem (1706-1790) i jego puszczaniem latawca w czasie burzy, oraz zanim James Clerk Maxwell (1831-1879) wyprowadził swoje równania, łączące pola magnetyczne z elektrycznymi, ale pola elektryczne są trudne do zmierzenia a astronomowie nie wiedzieli, że będą one im potrzebne. Zatem nigdy ich nie włączali do zaakceptowanego modelu grawitacyjnego, w jakim od zawsze działa Układ Słoneczny czy cały kosmos.

Oto dlaczego do dzisiaj, większość astrofizyków nigdy nie zaliczyło kursu elektrodynamiki czy dynamiki i wyładowań plazmy. Próbują opisać dynamikę plazmy przy pomocy równań stosowanych tylko do dynamiki płynów i efektów magnetycznych. To jest to, co Alfvén nazwał magneto-hydrodynamiką. Nie zdają sobie sprawy, że magneto oznacza również elektro. ZAWSZE. A to z kolei wyjaśnia, dlaczego ślepi astronomowie mówią o wietrze słonecznym, skręconym warkoczu czy falach uderzeniowych, zamiast o prądzie elektrycznym w plazmie, polach elektrycznych, skurczach plazmy typu "Z" i warstwach podwójnych. Wyjaśnia to również, dlaczego twierdzą oni, że linie pola magnetycznego nie mogą się gromadzić, łączyć i rekombinować.

Oto dlaczego do dzisiaj, większość astrofizyków nigdy nie zaliczyło kursu elektrodynamiki czy dynamiki i wyładowań plazmy. Próbują opisać dynamikę plazmy przy pomocy równań stosowanych tylko do dynamiki płynów i efektów magnetycznych. To jest to, co Alfvén nazwał magneto-hydrodynamiką. Nie zdają sobie sprawy, że magneto oznacza również elektro. ZAWSZE. A to z kolei wyjaśnia, dlaczego ślepi astronomowie mówią o wietrze słonecznym, skręconym warkoczu czy falach uderzeniowych, zamiast o prądzie elektrycznym w plazmie, polach elektrycznych, skurczach plazmy typu "Z" i warstwach podwójnych. Wyjaśnia to również, dlaczego twierdzą oni, że linie pola magnetycznego nie mogą się gromadzić, łączyć i rekombinować.

Wszechświat jest elektryczny ale i świadomy jednocześnie a więc na początku kiedy istniała ciemna i pusta przestrzeń, była już obecna INFORMACJA jak ma wyglądać materia. Na początku był to -można wprost powiedzieć- pusty choć nie próżniowy Wszechświat bez plazmowych sieci galaktyk, gwiazd, ich planet i życia biofizycznego. Od strony fizycznej był na początku wolną od materii przestrzenią pełną wyłącznie fotonów. Dokładniej protofotonów- eteru w stanie bezruchu o niskiej energii. Pełny substancji w której łatwo przenosił się ruch w postaci drgań elektromagnetycznych. Materia powstała później. Nie odwrotnie! Potem ...COŚ zmieniło ciśnienie w różnych punktach przestrzeni wywołując wysokie róznice napięcia aż do pierwszego wyładowania. Coś świadomego wprowadziło wibracje a raczej wibrację, starter który możemy określić jako biblijne SŁOWO – informacja która była „na początku". Od tego pierwszego boskiego grzmotu proces lawinowo zaczął się powtarzać dla innych części przestrzeni. Powstała sieć elektryczna w której plazmowych włóknach przypominających pioruny lecz bez dżwięku, w ciszy narodziły się nasze galaktyczne "domy". Cały Wszechświat od wtedy tworzy się i zmienia płynnie swoje parametry elektryczne w przestrzeni pomiędzy gromadami galaktyk i wewnątrz galaktyk co rzutuje na zmienność zachowań gwiazd, w tym także cykli słonecznych tej jedynej gwiazdy którą znamy świecącej tuż obok nas. Nawet planety podlegają tym prądom bezpośrednio. Pola magnetyczne indukują się z zewnątrz do wewnątrz w zależności od rezystancji przewodnika. W tym świetle terraforming Marsa polegałby nie na detonacji bomby tylko zrzuceniu asteroid lodowych z Pasa Planetoid na powierzchnię aby zwiększyć przewodnictwo planety. jednocześnie otrzymujemy tym sposobem poprawę w kwestii hydro, atmo i magnetosfery. Zawsze najpierw lepiej jest poukładać informacje, potem działać. Naukowcy są po prostu niedouczeni i w zrozumiały sposób zamistyfikowani obowiązującą do dziś, przestarzałą wobec nowych faktów, dziedziną nauki inżynieryjnej. Jeśli więc Wszechświat samoistnie tworzy się elektrycznie to z pewnością inne cywilizacje zamiast z przeciwległego krańca Wszechświata transportować minerały o bardzo dużej zawartości pierwiastków z wysoką liczbą atomową, mogą produkować je na miejscu za pomocą urządzeń o wysokich parametrach elektrycznych.

„Jeśli chcesz zrozumieć Wszechświat, zacznij myśleć w kategoriach energii, częstotliwości i wibracji.”

N. Tesla

„Jeśli chcesz zrozumieć Wszechświat, zacznij myśleć w kategoriach energii, częstotliwości i wibracji.”

N. Tesla

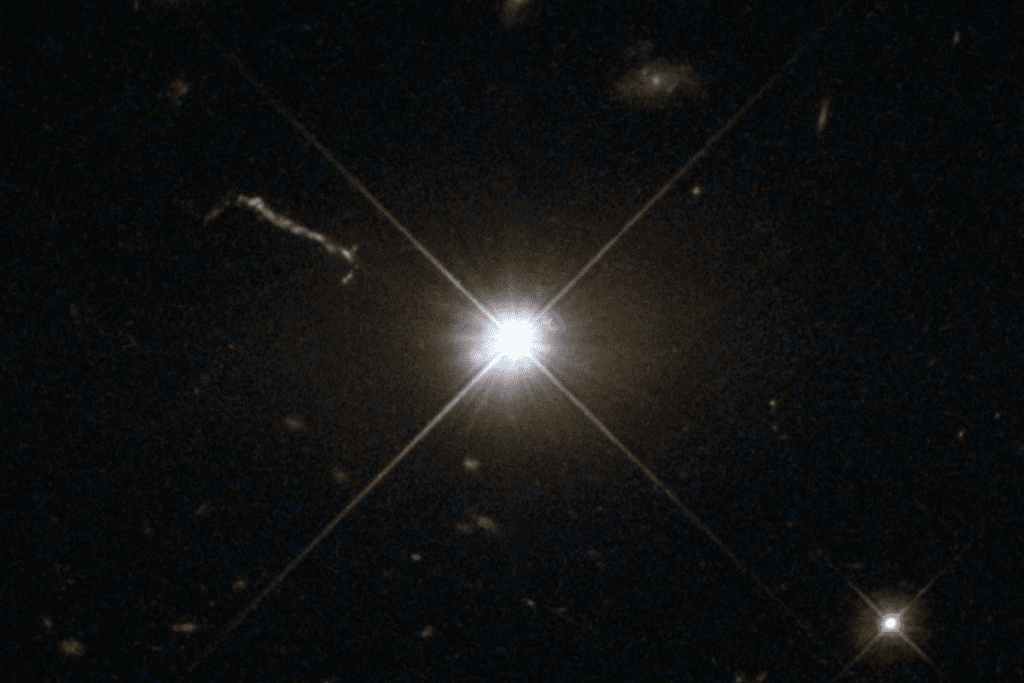

3C 273 to pierwszy obiekt, który został zidentyfikowany jako kwazar

3C 273 to pierwszy obiekt, który został zidentyfikowany jako kwazar